美光 HBM3E | 面向 AI 的高带宽内存

深入了解美光 HBM3E 在快速发展的 AI 领域的应用。美光的 HBM3E 高带宽内存拥有业界前沿的能效,功耗比竞品低 30%。HBM3E 提供超过 1.2 TB/s 的带宽以及出色的功率效率,可加速生成式 AI 创新。了解美光的前沿产品如何推动数据中心、工程、医学等领域的进步,帮助塑造 AI 的未来。

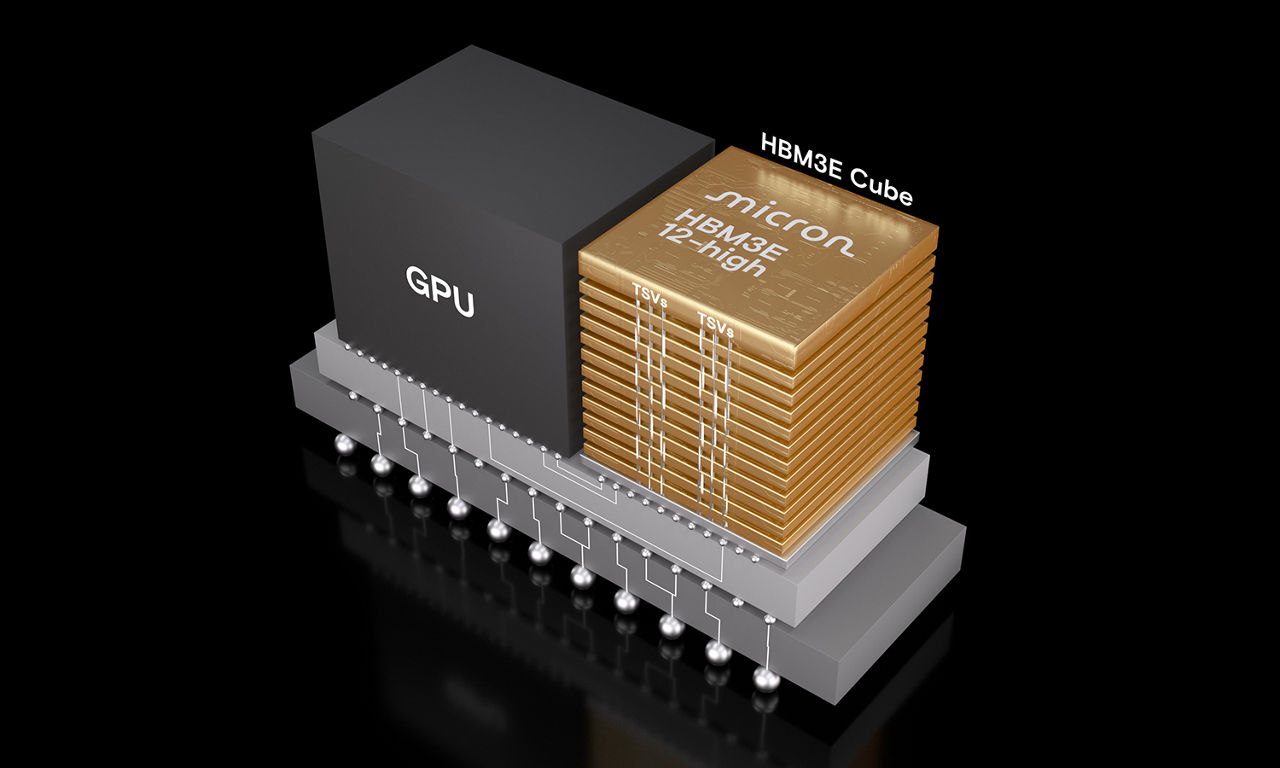

美光 12 层堆叠 36GB HBM3E 立方体现已开始送样

如今的生成式 AI 为提供更优结果和把握新的需求机会而不断扩展,对数据量的需求越来越大。美光行业前沿的 1β 内存技术加上在封装领域的技术进步,可确保数据高效地传入和传出 GPU。美光的 8 层堆叠和 12 层堆叠 HBM3E 内存可比竞品节约 30% 的功耗,将进一步推动 AI 创新。

相较于其他竞品,美光 HBM3E 的功耗降低约 30%,有助于减少数据中心的运营成本。其 8 层堆叠 24GB 解决方案将应用于 NVIDIA H200 Tensor Core GPU,于 2024 年第二季度开始出货。